3 Digital Literacy, Digital Criticism

3.1 Digital Literacy, Data Literacy

Unter Data Literacy wird die Kompetenz verstanden, Daten zu sammeln, zu managen, zu evaluieren und zu nutzen,1 eine Kompetenz, die jede:r für den mittlerweile unvermeidlichen Umgang mit Daten verschiedenster Art im eigenen Alltag entwickeln sollte. Je nach Forschungsdisziplin ergeben sich weiter gewisse Spezifika, wobei Studierenden der Geisteswissenschaften ein Thema wie Algorithmenkritik nicht als erstes in den Sinn kommt, wenn es um die im Studium zu erwerbenden Kompetenzen geht.2 Aber auch ohne den Quellcode von machine-learning-Software im Detail zu verstehen, ermöglicht ein grundlegendes Verständnis von und ein Wissen über die Funktionsweisen solcher Anwendungen einen reflektierten Umgang mit diesen. Eine solche Art von Digital bzw. Data Literacy ist vor allem dann relevant, wenn es um die Interpretation von Ergebnissen geht, die scheinbar objektiv sind, bzw. scheinbar objektiv entstanden. Ein gutes Beispiel hierfür sind die Ergebnislisten bei Suchanfragen in einer Suchmaschine. Je nachdem, welchen Anbieter Sie nutzen, spielen verschiedene Umstände in die Generierung von Trefferlisten hinein, beispielsweise Ihre Suchhistorie, sodass search neutrality nicht mehr gewährleistet ist.3

Gehen Sie auf die Bilder-Suche von Google und suchen Sie nach “historian”. Was sehen Sie?

Wüsste ich nichts über Geschichtswissenschaftler:innen, würde ich aufgrund der Ergebnisse meiner Suche davon ausgehen, “a historian” wäre meist ein alter, weißer Mann mit Brille, Bart und einem großen Bücherregal; wenn Sie sich am Departement Geschichte der Uni Basel umsehen, dürfte ein etwas anderer Eindruck entstehen. Die Ergebnisse von Suchmaschinen, die für ihr Funktionieren Algorithmen anwenden, sind biased, verzerrt: Sie beruhen auf vorangegangenen Suchen, Vorlieben, geographischem Standort – und auf von Menschen eingegebenen Metadaten, also Daten mit Informationen über andere Daten. Ein Bewusstsein hierfür und das Hinterfragen von Datensätzen gehören also mit zur Arbeit in einer digitalisierten Welt.

3.2 Digital Criticism, Data Criticism

Digitalisierte Quellen ebenso wie rein digitale erfordern eine erweiterte Art von Quellenkritik – im Einführungskurs an der Universität Basel lernen Sie die Grundlagen klassischer Quellenkritik:

Woher kommt eine Quelle, wer hat sie unter welchen Umständen und zu welchem Zweck erstellt? Welche Absichten können darin verborgen sein, und welche Verzerrungen können sich durch sie ergeben? Welche Tendenzen könnten sich in hochmittelalterlichen Herrscherchroniken verstecken, wenn der Verfasser in direkter Abhängigkeit des Auftraggebers stand? Wie sind Zeug:innenaussagen in Hexenprozessen zu bewerten, die unter Anwendung körperlicher Strafe entstanden sind? Mit wie viel Vorsicht sind die Inhalte eines Tagebuchs zu bewerten, das allem Anschein nach mit Blick auf eine spätere Veröffentlichung verfasst wurde?

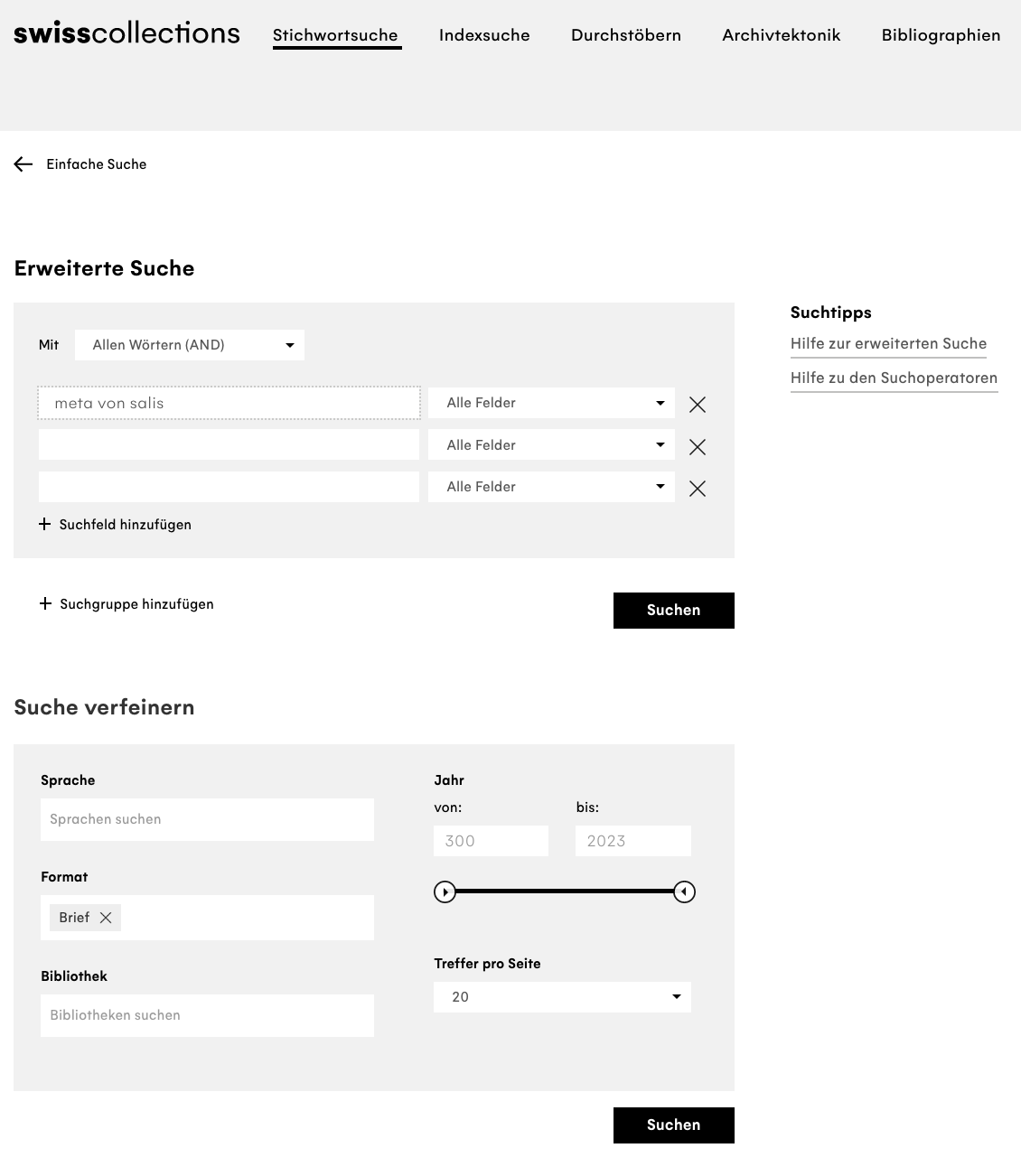

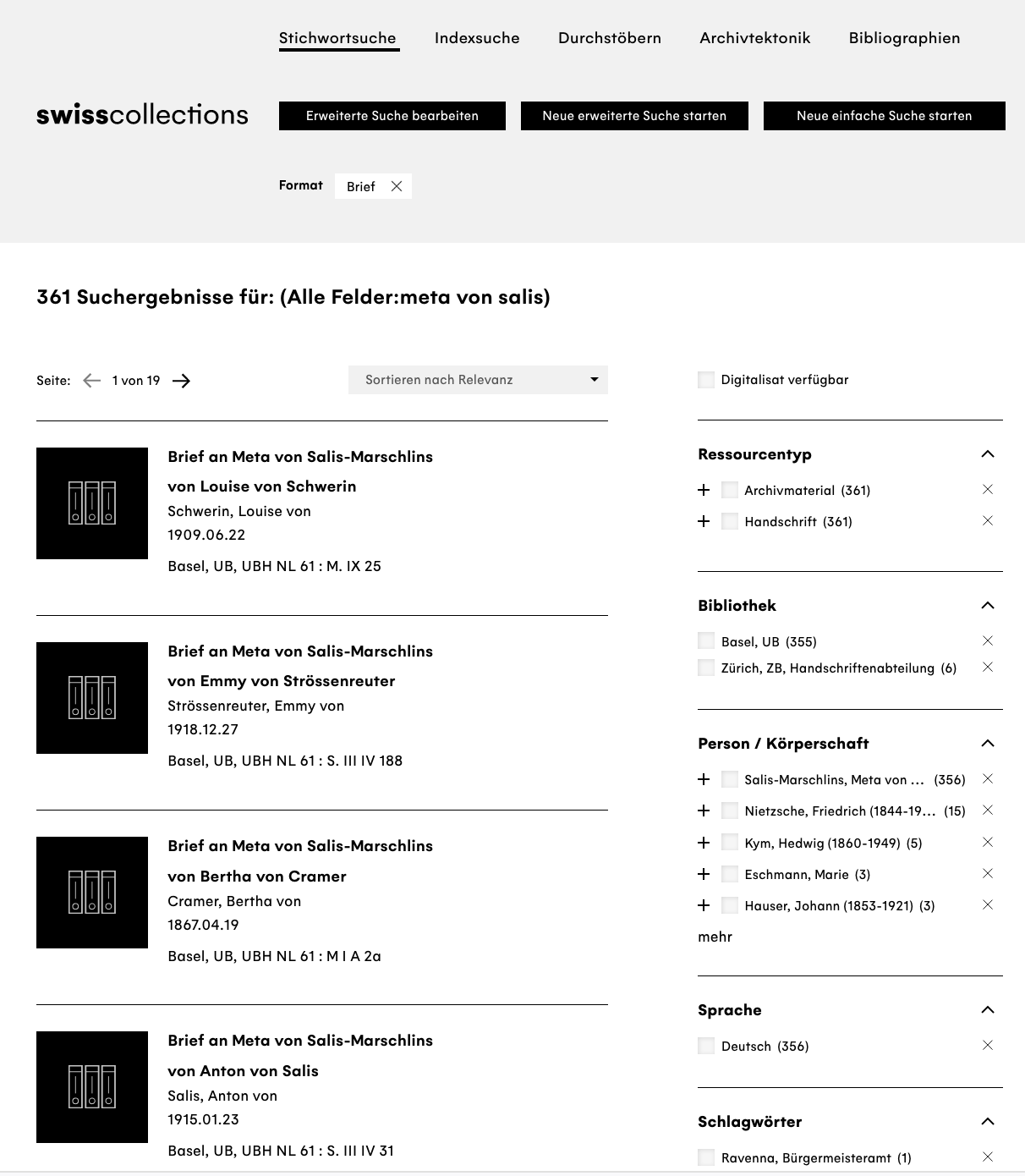

Neben der inneren Kritik geht es bei der Arbeit mit Quellen immer auch um Fragen der Korpusbildung: Wie kann eine Quellengrundlage erstellt werden, die für Beantwortung einer spezifischen historischen Fragestellung belastbar und aussagekräftig genug ist und gleichzeitig in angemessener Zeit bearbeitet werden kann? Hinzu kommen Spezifika bei der Arbeit mit unterschiedlichen Quellenformen bzw. -formaten: Bei analogen Quellen, die auch in digitaler Form zur Verfügung stehen, besteht die Gefahr, dass ein Thema, ein Bereich, ein Aspekt vernachlässigt wird, wenn nur die unmittelbar verfügbaren, digitalisierten Bestände zur Korpusbidlung genutzt werden. Wenn Sie sich beispielsweise für die Schweizer Historikerin und Frauenrechtlerin Meta von Salis (1855–1929) und deren briefliche Korrespondenz – Friedrich Nietzsche war einer ihrer Brieffreunde – interessieren und über die Suchplattform für historische Schweizer Bestände, swisscollections, in nationalen Bibliotheken und Archiven nach entsprechenden Dokumenten suchen, erhalten Sie 361 Treffer:

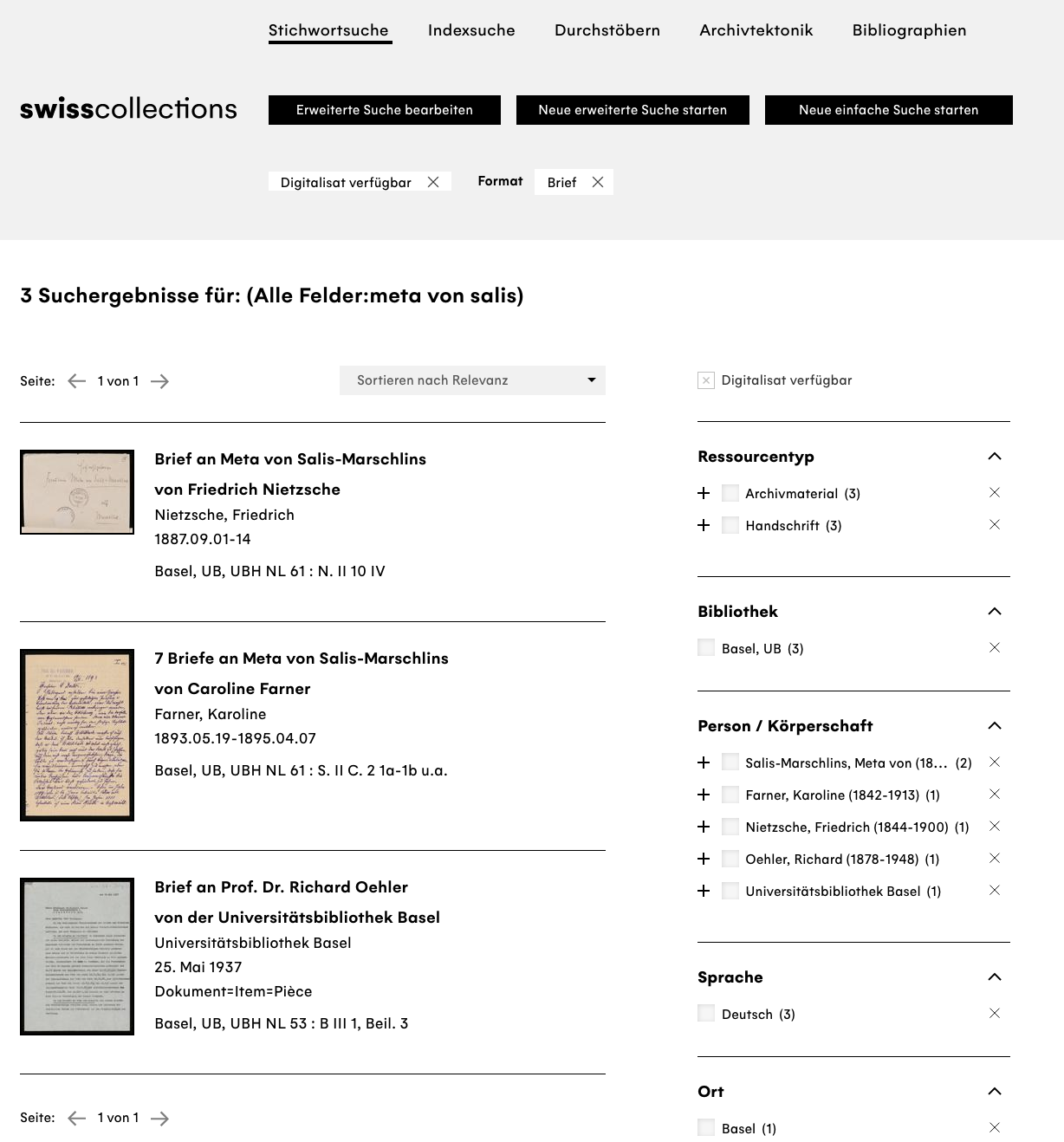

Digital verfügbar waren hiervon im Oktober 2022 lediglich drei Einträge, wobei der erste ein Brief von Nietzsche an Meta von Salis ist, der zweite Eintrag umfasst sieben Briefe von Caroline Farner, und der dritte Eintrag ist weder an noch von Meta von Salis, sondern hat sie nur zum Thema:

Ihnen würde bei einer Korpuserstellung vom Schreibtisch aus, also nur mit den angezeigten Digitalisaten, also der Großteil der Überlieferung fehlen, und Ihre Untersuchungsergebnisse wären wohl sehr verzerrt, würden Sie statistische Aussagen treffen wollen: Meta von Salis unterhielt brieflichen Kontakt zu einem Mann und einer Frau, das Geschlechterverhältnis wäre also ausgeglichen; und Frauen schreiben im Schnitt mehr Briefe an Meta von Salis als Männer. Beim Blick auf alle Suchergebnisse würden sich Ihre Aussagen aber sehr ändern, und es würde sich lohnen, diese Verzerrung, diesen Bias aus Ihrer Datengrundlage zu entfernen.

Hinzu kommt natürlich immer das grundlegende Problem bei der Suche nach Quellen: swisscollections und ähnliche Portale können nur anzeigen, was die Kooperationspartner:innen zur Verfügung stellen. Hat eine Bibliothek Briefe von Meta von Salis in ihrem Bestand, diese aber noch nicht als Datensatz erfasst, wissen Sie im Gegensatz zum obigen Beispiel nicht einmal, dass Ihnen etwas entgehen würde, dass in Ihrem Korpus überhaupt ein Bias vorhanden ist.

Ähnliche Vorsicht zur Vermeidung von Verzerrungen in der Datengrundlage gilt bei der Arbeit mit rein digitalen Daten, beispielweise bei der Auswertung von Datensätzen aus Befragungen. Wenn Sie sich am 27.10.2022 vor die Universitätsbibliothek in Basel stellen und einen Tag lang mithilfe eines kurzen Fragebogens und einer Tabellendatei erfassen, wie zufrieden die befragten Personen mit dem Essen in der Unimensa sind, werden Sie am Ende einen Datensatz erhalten, in dem sich vermutlich über 80% der Befragten für besseres und nahezu 100% für günstigeres Essen in der Mensa aussprechen – eine gute Schlagzeile für die BZ, die sich auf die neuesten Ergebnisse einer wissenschaftlichen Studie berufen kann. Führen Sie die gleiche Umfrage eine Woche später, mitten während der Herbstmesse durch, werden die Ergebnisse wohl erheblich anders aussehen. Die Wahrscheinlichkeit, dass die Mensa infolge der BZ-Schlagzeile innerhalb weniger Tage den Menüplan überarbeitet und die Preise herabgesetzt hat, ist dabei wohl geringer als diejenige, dass sich Ihr Sample, die Auswahl an Datenpunkten, also befragten Personen, durch die Messe stark verändert hat: Im Umkreis der Bibliothek treffen Sie nun nicht mehr vor allem Studierende und andere Uni-Angehörige an, sondern auch Messebesucher:innen vom Petersplatz. Auch hier sind Verzerrungen entstanden, ähnlich wie beim vorherigen Beispiel mit den Briefen: Wenn aus einer Gesamtheit nur eine spezifische Untermenge beobachtet wird, die sich durch ein gemeinsames Merkmal von der Gesamtheit unterscheidet – digitalisierte Quelle oder Besucher:in der Universitätsbibliothek –, ist die Datengrundlage und damit die Untersuchungsergebnisse biased. Um bei Daten, die Sie nachnutzen, eventuell vorhandene Verzerrungen nicht weiterzutransportieren, ist das Üben von Datenkritik eine essentielle Kompetenz.

Zur Tatsache, dass Daten eben nicht “gegeben” sind (lat. dare, datum: geben, gegeben), sondern gemacht, und daher entsprechend interpretiert werden müssen, finden Sie ein gutes Interview von Roopika Risam (2020);4 zur Zementierung von Klischees durch Übersetzungsalgorithmen gibt es einen Artikel in der Republik von Marie-José Kolly und Simon Schmid (2021);5 und über die Macht von Data Science und dem Änderungspotential von Data Feminism haben Catherine D’Ignazio und Lauren F. Klein 2020 ein ganzes Buch veröffentlich.6

Zur Frage, wie sich die digitale Wende, der digital turn, auf die Quellenkritik auswirkt, sehen Sie sich dieses kurze Video des Projekts Ranke.2 – Quellenkritik im digitalen Zeitalter an:7

Eine Handreichung zum Umgang mit digitalisierten und digitalen Daten, das im selben Projekt erarbeitet wurde, finden Sie hier.

3.3 Künstliche Intelligenz und Algorithmenkritik

Mit dem Release von ChatGPT-3 der Firma OpenAI im Winter 2022 hat sich die Nutzung künstlicher Intelligenz (KI) auf einen Schlag für einen sehr großen Personenkreis geöffnet: Ein Chatbot steht, nach einmaliger Registrierung, über eine URL den unterschiedlichsten Fragen Rede und Antwort, und erklärt wahlweise Fermats letzten Satz, produziert Sonette im Stil Shakespeares über die Liebe einer Emmentalers zu einer Büroklammer oder fasst den in den 1980er-Jahren in Deutschland geführten Historiker:innenstreit über die Singularität des Holocaust zusammen. Technisch handelt es sich bei ChatGPT um ein generatives Sprachmodell (Generative Pre-trained Transformer), ein sog. Large Language Model (LLM), das mit einem sehr großen Datensatz trainiert wurde – etwa 1 Billion Wörter aus sechs Millionen Wikipedia-Artikeln, Millionen Webseiten und digitalisierten Büchern, insgesamt etwas 570 GB –, um auf dieser Grundlage neue, der Anfrage bzw. Eingabe der Nutzer:innen entsprechende Texte zu produzieren.8 Bittet man ChatGPT selbst, das Prinzip eines generativen Sprachmodells und seines Algorithmus zu erklären, erhält man folgende Antwort:

Hallo! Gerne erkläre ich dir das Prinzip hinter einem generativen Sprachmodell und meinem Algorithmus.

Ein generatives Sprachmodell ist ein künstlicher Intelligenz-Algorithmus, der darauf trainiert wird, Texte zu erzeugen, die einer bestimmten Sprache oder einem bestimmten Stil entsprechen. Das Modell nutzt dabei eine statistische Methode namens Wahrscheinlichkeitsverteilung, um die Wahrscheinlichkeit zu bestimmen, mit der ein bestimmtes Wort oder eine bestimmte Phrase in einem Text auftaucht.

Das Ziel des Algorithmus besteht darin, Texte zu generieren, die natürliche Sprachstrukturen und -muster aufweisen, sodass sie für den Menschen verständlich und lesbar sind. Das generative Sprachmodell kann dabei verschiedene Ansätze verfolgen, wie zum Beispiel die Verwendung von rekurrenten neuronalen Netzen (RNN) oder Transformer-Modellen.

Als ChatGPT, basiere ich auf der GPT-3.5 Architektur und nutze ebenfalls ein Transformer-Modell. Mein Algorithmus nutzt eine große Menge an Textdaten, um Sprachmuster und -strukturen zu erlernen und kann anschließend Texte generieren, die dieser Sprache ähnlich sind.

Um Texte zu erzeugen, nutzt mein Algorithmus eine sogenannte autoregressive Methode, bei der er das zuvor erzeugte Wort oder die zuvor erzeugte Phrase als Input verwendet, um das nächste Wort oder die nächste Phrase vorherzusagen. Auf diese Weise wird ein Text Schritt für Schritt erzeugt, wobei jeder Schritt auf dem vorherigen basiert.

Durch die ständige Anpassung der Gewichtungen im Modell, je nachdem wie gut es darin ist, den nächsten Textsatz vorherzusagen, wird das generative Sprachmodell im Laufe der Zeit immer besser darin, realistische und gut klingende Texte zu erzeugen.9

Das bedeutet, dass die Antworten besonders gut bzw. sinnvoll für Fragen zu Themen sind, für die sehr viel Trainingsmaterial vorlag. Das bedeutet auch, dass alles, was nach Abschluss des Trainings im November 2021 online gestellt wurde, nicht mehr Eingang in das Modell 3.5 gefunden hat; hier wird zwar aktuell nachgeholt, und je nach Release und Modell gibt es hier Unterschiede, aber Ereignisse wie den Ukraine-Krieg kennt ChatGPT (noch) nicht.10 Auch ist es nicht immer einfach, die Ausgewogenheit und Qualität der Antworten richtig abzuschätzen – bei der Erstellung von Programmierfunktionen lässt sich der Vorschlag eines Chatbots direkt testen. Bei Fragen, die etwas offener gestellt sind, bieten die LLMs sehr überzeugend klingende Antworten – die aber natürlich geprägt sind vom zugrundeliegenden Trainingsmaterial, Modell und Trainingsmethoden, die nicht immer transparent sind.11 Auf die Frage nach den Namen von “ten medieval philosophers” gibt ChatGPT-4o zehn Männer aus, sieben davon aus West-/Zentraleuropa.12 Erst auf den Hinweis, dass die Liste recht männerlastig und weiß sei, bekommt man eine größere Auswahl arabischer und persischer Philosophen und (westlicher) Frauen. Es braucht noch eine weitere Nachfrage, um auch indische und chinesische Namen zu erhalten. Der Großteil der Texte, die ins Training einflossen, sind englisch und damit größtenteils aus dem angloamerikanischen Raum. Ein Ungleichgewicht zugunsten Wissensproduktion und Meinungen aus diesem (Sprach-)Raum ist daher unvermeidlich und muss bei der Nutzung stets mitbedacht werden.

Mit Blick auf die obige, tadellos formulierte Antwort zum eigenen Funktionieren liegt es natürlich nahe, LLMs für alle Arten von Schreibarbeiten zur Hilfe zu ziehen, und die Aufregung im (Hoch-)Schulbereich war mitunter groß13 – auch, weil die Programme erfundene Fakten im Brustton der Überzeugung formulieren oder auf nicht existierende Referenzen verweisen. Bei unkritischer Übernahme der Antworten und Ausgabe des Textes als eigenes Produkt kommt es also nicht nur zur Täuschung in Bezug auf die eigenen Fähigkeiten, sondern es werden auch falsche Informationen übernommen und mitunter verbreitet, beispielsweise in Referaten. Zahlreiche Hochschulleitungen haben auf die neue Technik reagiert und Codes of Conduct erstellt; an der Universität Basel gibt es eine erweiterte Eigenständigkeitserklärung, in der versichert wird, mit KI erstellte Passagen als solche zu kennzeichnen – Software, die mithilfe KI erstellte Texte als solche identifiziert, gibt es natürlich auch.[Das Vizerektorat Lehre hat einen Leitfaden “Aus KI zitieren” erstellt.]

Überlegungen zum konstruktiven Einsatz generativer Sprachmodelle, als Lernassistent,14 Schreibcoach oder Hilfe bei der Recherche, gibt es ebenso, und gelungene Beispiele, wie ChatGPT in der Lehre eingesetzt werden kann.15 Zentral für eine gewinnbringende und informierte Nutzung ist sicher ein ungefähres Wissen über die Funktionsweise des Algorithmus und die Bereitschaft, erhaltene Antworten kritisch zu prüfen und ggf. zu verwerfen.

Ridsdale, Chantel; Rothwell, James; Smit, Mike u. a.: Strategies and Best Practices for Data Literacy Education Knowledge Synthesis Report, 2015, S. 8. Online: <https://doi.org/10.13140/RG.2.1.1922.5044>.↩︎

Verschiedene Organisationen und Interessensverbände machen sich hierzu Gedanken; die deutsche “Gesellschaft für Informatik” hat ein Grundlagenpapier erstellt, in dem es um Data Literacy und Data Science Education als digitale Kompetenzen in der Hochschulausbildung geht: https://gi.de/fileadmin/GI/Hauptseite/Aktuelles/Aktionen/Data_Literacy/GI_DataScience_2018-04-20_FINAL.pdf.↩︎

Alternative Suchmaschinen sind zum Beispiel Startpage oder DuckDuckGo.↩︎

Risam, Roopika: “It’s Data, Not Reality”: On Situated Data With Jill Walker Rettberg, 06.2020. Online: <https://medium.com/nightingale/its-data-not-reality-on-situated-data-with-jill-walker-rettberg-d27c71b0b451>, Stand: 16.08.2022.↩︎

Kolly, Marie-José; Schmid, Simon: Sie ist hübsch. Er ist stark. Er ist Lehrer. Sie ist Kindergärtnerin, in: Republik, 04.2021. Online: <https://www.republik.ch/2021/04/19/sie-ist-huebsch-er-ist-stark-er-ist-lehrer-sie-ist-kindergaertnerin>, Stand: 23.08.2022.↩︎

D’Ignazio, Catherine; Klein, Lauren F.: Data feminism, 2020. Online: <https://direct.mit.edu/books/book/4660/Data-Feminism>.↩︎

Eine Selbstlerneinheit zum Thema finden Sie hier: https://ranke2.uni.lu/u/archival-digital-turn/.↩︎

Eine ausführliche und anschauliche Erklärung von Helmut Linde findet sich unter https://www.golem.de/news/kuenstliche-intelligenz-so-funktioniert-chatgpt-2302-171644.html, ein Einführungsvortrag mit besonderem Blick auf Konsequenzen für die Hochschullehre von Thomas Arnold unter https://www.youtube.com/watch?v=-c8ogAwX6KI.↩︎

ChatGPT-3.5-Antwort, Anfrage zu „Wie funktioniert ein generatives Sprachmodell und der dazugehörige Algorithmus?“, 11. November 2022.↩︎

Die neueste Version von ChatGPT, GPT-4.o, hat keine neueren Trainingsdaten als 3.5; perplexity gibt Juli 2023 als cut-off-Datum an, Googles Gemini den Zeitraum Ende 2023 bis Anfang 2024. Zwar fließen neueste Onlineartikel mit in Antworten ein, aber je nach Ereignis fehlen substantielle Hintergrundinformationen aus der Zeit zwischen dem Abschluss des Trainings und einer Online-Suche einige Monate später.↩︎

Das “Open” im Firmennamen OpenAI, das hinter ChatGPT steht, ist also nicht Programm. Der vollständige technische Report, der viele grundlegende Parameter auslässt, ist hier abrufbar. Zur Kritik am Vorgehen von OpenAI siehe u.a. einen Artikel von Leigh Mc Gowran. Eine Open-source-Alternative mit offenem Trainingsset und Modell ist z.B. dolly. Das LLM perplexity wirbt damit, mit Fußnoten auf genutzte Onlinequellen zu verweisen und die Ergebnisse somit nachvollziehbarer zu machen.↩︎

ChatGPT-4o-Antwort, Anfrage zu „Name ten medieval philosophers“, 3. September 2024.↩︎

Siehe z.B. in Basel jetzt, 19.01.2023; NDR, 09.02.2023; bajour, 20.03.2023; 20 minuten, 24.03.2023.↩︎

Siehe z.B. Pedagogical Educational Tutor (PET), entwickelt an der Universität Hohenheim, mit Einführungsvideo.↩︎

U.a von Andrea Klein oder Ethan Mollick.↩︎